Tema 1: Análisis espectral de series temporales(1)

Modelos de series temporales

Contenido

Modelos de series temporales

Procesos estacionarios

Estimación

Ejemplos

Proceso lineal

ARIMA(p,d,q)

En R

Modelos de series temporales

Definición: Un proceso estocástico es una familia de variables aleatorias (v.a.) indexada por un conjunto \(\mathcal{T}\), \[\left\lbrace X(t), ~t \in \mathcal{T} \right\rbrace\]

Generalmente:

- \(\mathcal{T}\) puede ser \(\mathbb{R}\), \(\mathbb{Z}\) o \(\mathbb{N}\).

- \(X(t)\) es una v.a. real.

Para cada \(t \in \mathcal{T}\), \(X(t)\) es una v.a. definida sobre \(\Omega\) y

\(X(t)\) es una función de dos argumentos \(X(t,\omega)\), \(t \in \mathcal{T}, \omega \in \Omega\).

Para cada \(\omega \in \Omega\), obtenemos una función de \(t\), o sea, una observación de un proceso estocástico, una realización de un proceso estocástico.

Denotemos por \(X^{(1)}(t), X^{(2)}(t),...\).

Para un \(t\) fijo, se puede visualizar la distribución de \(X(t)\), por medio de alguna técnica estadística como: histograma, cálculo de medias, variancia, etc.

Para \(t_1,t_2,...,t_n\) arbitrarios de \(\mathcal{T}\) y defina la distribución conjunta \[F_{X_{t_1},...,X_{t_n}}(c_{1},...,c_{n} \mid t_1,...,t_n) = P\left(X_{t_1}\leq c_{1}, X_{t_2}\leq c_{2},...,X_{t_n} \leq c_{n} \right).\]

El proceso estocástico \(\left\lbrace X(t), ~t \in \mathcal{T} \right\rbrace\) será especificado si conocemos todas las distribuciones de dimensión finita de todo \(n\geq 1\).

En este caso, se trata de la especificación de un modelo de series temporales.

Por ejemplo,

- Si \(n=1\), conocemos todas las distribuciones unidimensionales,

- Si \(n=2\), conocemos todas las distribuciones bidimensionales,

- …

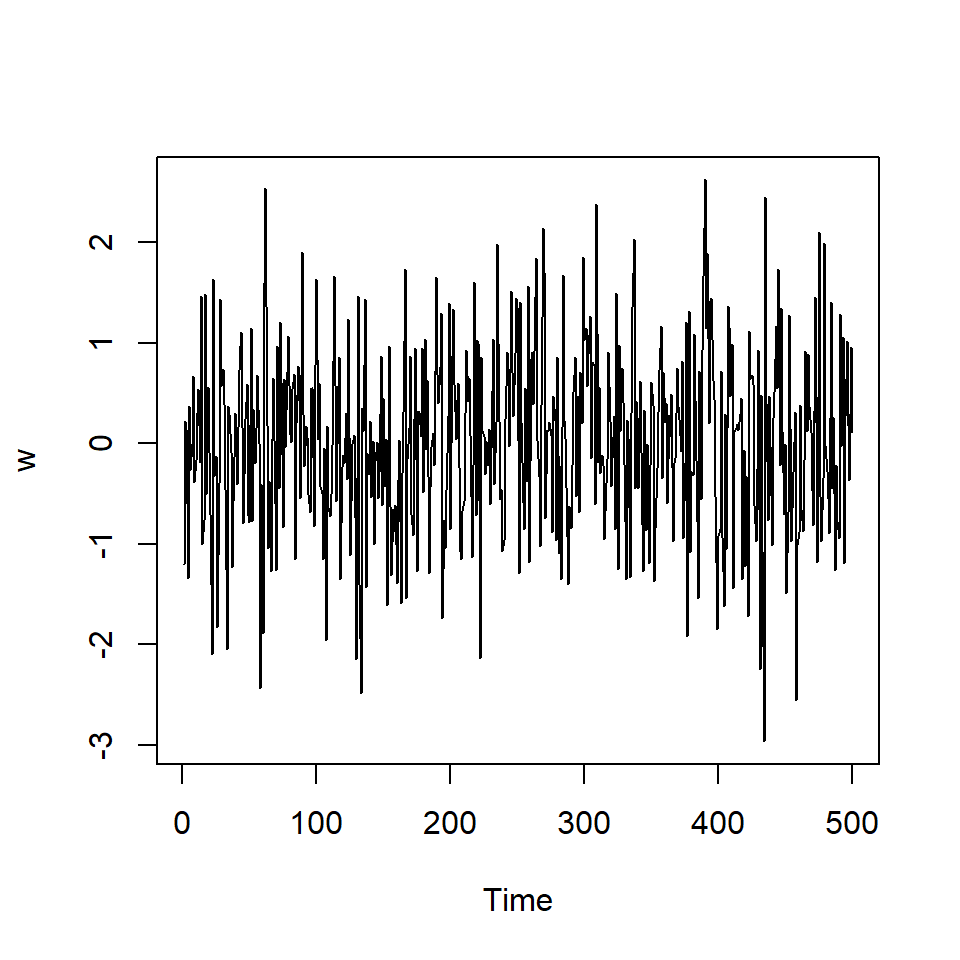

Ruido blanco

Una colección de variables aleatorias no correlacionadas, \(w_t\), con media 0 y variancia \(\sigma_w^2\).

Denotado por \(w_t \sim wn(0,\sigma_w^2)\).

Si una secuencia de variables es i.i.d., i.e. \(w_t \sim iid(0,\sigma_w^2)\), entonces \(w_t \sim wn(0,\sigma_w^2)\). ¡El inverso no es cierto!

Sin embargo, si un ruido blanco es Gaussiano, entonces \(w_t \overset{iid}{\sim} N(0,\sigma_w^2)\).

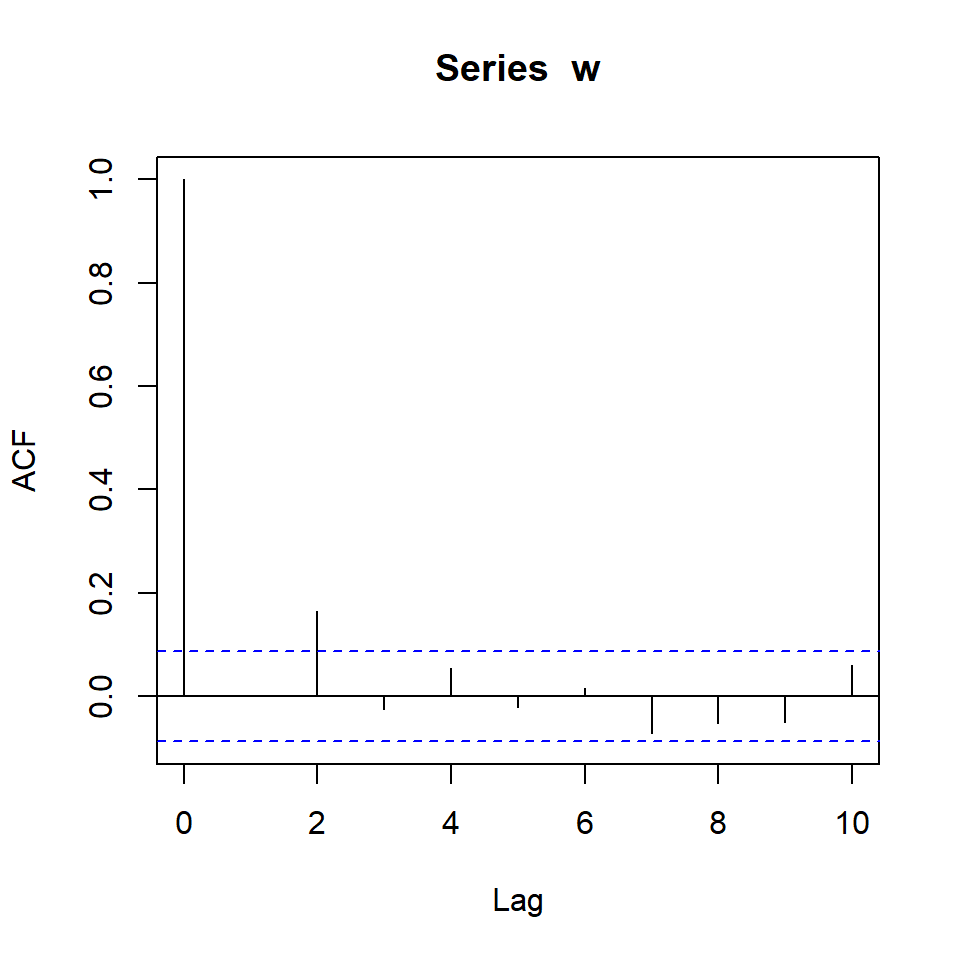

Simulación de una colección de \(w_t \sim N(0,1)\) con \(T=500\).

Medidas de dependencia

- Una descripción completa de un modelo de series temporales es proporcionado por la distribución de probabilidad conjunta, i.e. dados tiempos arbitrarios \(t_1,...,t_n\) para \(n\) entero positivo y \(c_1,...,c_n\) n valores constantes:

\[F_{t_1,...,t_n}(c_1,...,c_n)=P\left(X_1\leq c_1, X_2\leq c_2,...,X_t \leq c_t \right)\]

Aunque esa distribución describe los datos globalmente, en la práctica, esa distribución multidimencional es dificil de conocer, por lo que restringe el análisis a los momentos bajos (media, variancia, covariancia).

La distribución marginal en el tiempo \(t\), \[F_t(x)=P(X \leq x)\]

La función densidad marginal en el tiempo \(t\), \[f_t(x)= \frac{\partial F_t(x)}{\partial x}.\]

- La función de media para el tiempo \(t\) es definida por

\[\mu_t= E(X_t)=\int_{-\infty}^\infty f_t(x)dx.\]

- La función de autocovariancia es definida por

\[\gamma_X(t,s)=\gamma(t,s)= Cov(X_t,X_s)=E\left[ (X_t-\mu_t)(X_s-\mu_s) \right].\]

Mide la dependencia lineal entre dos puntos de tiempo de la misma serie.

La función de variancia en el tiempo \(t\) es definida por \[\gamma_X(t,t)=Var(X_t)=\sigma_t^2.\]

- La función de autocorrelación es definida por

\[\rho_X(t,s)=\frac{\gamma(t,s)}{\sqrt{\gamma(t,t)\gamma(s,s)}}\]

En la práctica, nos interesa también estimar estas cantidades: \(\mu_t\), \(\sigma_t^2\), \(\gamma(t,s)\).

Si tuvieramos \(m\) realizaciones, se puede calcular

\[\hat{\mu}_t= \frac{X^{(1)}(t)+X^{(2)}(t)+...+X^{(m)}(t)}{m}.\]

- Pero en la práctica solamente se tiene una trayectoria.

Procesos estacionarios

Contenido

Modelos de series temporales

Procesos estacionarios

Estimación

Ejemplos

Proceso lineal

ARIMA(p,d,q)

En R

Procesos estacionarios

Definición: Un proceso estrictamente estacionario es un proceso estocástico cuyo comportamiento de cada colección de valores \[\left\lbrace X_{t_1},X_{t_2},...,X_{t_k} \right\rbrace\] es idéntico a un conjunto bajo un cambio de tiempo \[\left\lbrace X_{t_1+h},X_{t_2+h},...,X_{t_k+h} \right\rbrace.\] Esto es, \[P\left(X_{t_1} \leq c_1,...,X_{t_k} \leq c_k \right)=P\left(X_{t_1+h}\leq c_1,...,X_{t_k+h} \leq c_k \right)\] para todo \(k=1,2,...\), todo tiempo \(t_1,...,t_k\), todas las constantes \(c_1,...,c_k\) y todos los cambios de tiempo \(h=0, \pm 1, \pm 2,...\).

Definición: un proceso débilmente estacionario es un proceso con variancia finita tal que 1. la función de la media es constante \[\mu(t):=\mu_t=E(X_t)=\mu\]

- La función de autocovariancia depende solamente de la diferencia de dos puntos \(t, t+h\) \[\gamma(t,t+h)=Cov(X_t,X_{t+h})=Cov(X_0,X_h):=\gamma(h).\]

Consecuentemente, la función de autocorrelación de un proceso estacionario es definido como

\[\rho(h)=\frac{\gamma(t,t+h)}{\sqrt{\gamma(t+h,t+h),\gamma(t,t)}}=\frac{\gamma(h)}{\gamma(0)}.\]

- En la práctica, se refiere simplemente a un proceso estacionario de segunda orden o proceso estacionario.

Estimación

Contenido

Modelos de series temporales

Procesos estacionarios

Estimación

Ejemplos

Proceso lineal

ARIMA(p,d,q)

En R

Estimación

- Si una serie es estacionaria, la media \(\mu_t=\mu\) es constante y podemos estimarla usando la media muestral

\[\bar{X}=\frac{\sum\limits_{t=1}^T X_t}{T}.\] - Resultados teóricos: se puede probar que \[E\left[\bar{X}\right]=\mu.\] \[Var\left[\bar{X}\right]=\frac{1}{T} \sum_{h=-n}^n \left(1-\frac{|h|}{T} \right) \gamma_X(h).\]

La función de autocovariancia muestral es definida por \[\hat{\gamma}_X(h)=\frac{1}{T}\sum_{t=h+1}^{T} (X_{t}-\bar{X})(X_{t-h}-\bar{X}),\] con \(\hat{\gamma}_X(-h)=\hat{\gamma}_X(h)\) para \(h=0,1,...,T-1\).

Y la función de autocorrelación muestral es definida por \[\hat{\rho}_X(h)=r_X(h)=r_h=\frac{\hat{\gamma}_X(h)}{\hat{\gamma}_X(0)}\]

\[=\frac{\sum\limits_{t=h+1}^{T} (X_{t}-\bar{X})(X_{t-h}-\bar{X})}{\sum\limits_{t=1}^{T} (X_{t}-\bar{X})^2}.\]

Propiedad: Si \(X_t\) tiene sus primeros 4 momentos finitos, y \(X_t\) es ruido blanco, entonces para \(T\) suficientemente grande, la función de autocorrelación \(\hat{\rho}_X(h), h=1,2,..., H\) donde \(H\) es un valor cualquier pero fijo, es aproximadamente normal con media cero y desviación estándar \[\sigma_{\hat{\rho}_X(h)}=\frac{1}{\sqrt{T}}.\]

Nota:

- Con este resultado, si se tiene un ruido blanco, entonces se espera que con aproximadamente 95% de confianza, las \(\hat{\rho}_X(h)\) deberían caer dentro del intervalo \(\left( \frac{-2}{\sqrt{T}},\frac{2}{\sqrt{T}} \right)\). puede estimar intervalos de confianza e identificar aquellos rezagos que tienen autocorrelación significativa.

- En la práctica, se grafica los pares ordenados \((h,r_h),h=1,2,...\) para visualizar la función de aucorrelación muestral. Este gráfico se denomina correlograma.

Ejemplos

Contenido

Modelos de series temporales

Procesos estacionarios

Estimación

Ejemplos

Proceso lineal

ARIMA(p,d,q)

En R

Ruido blanco

- Si \(w_t \sim wn(0,\sigma_w^2)\), la función de autocorrelación es

\[\rho_w(t,s)=\left\lbrace \begin{aligned} 1, & & t = s \\ 0, & & t \neq s, \end{aligned} \right.\]

o

\[\rho_w(h)=\left\lbrace \begin{aligned} 1, & & h = 0 \\ 0, & & h \neq 0, \end{aligned} \right.\]

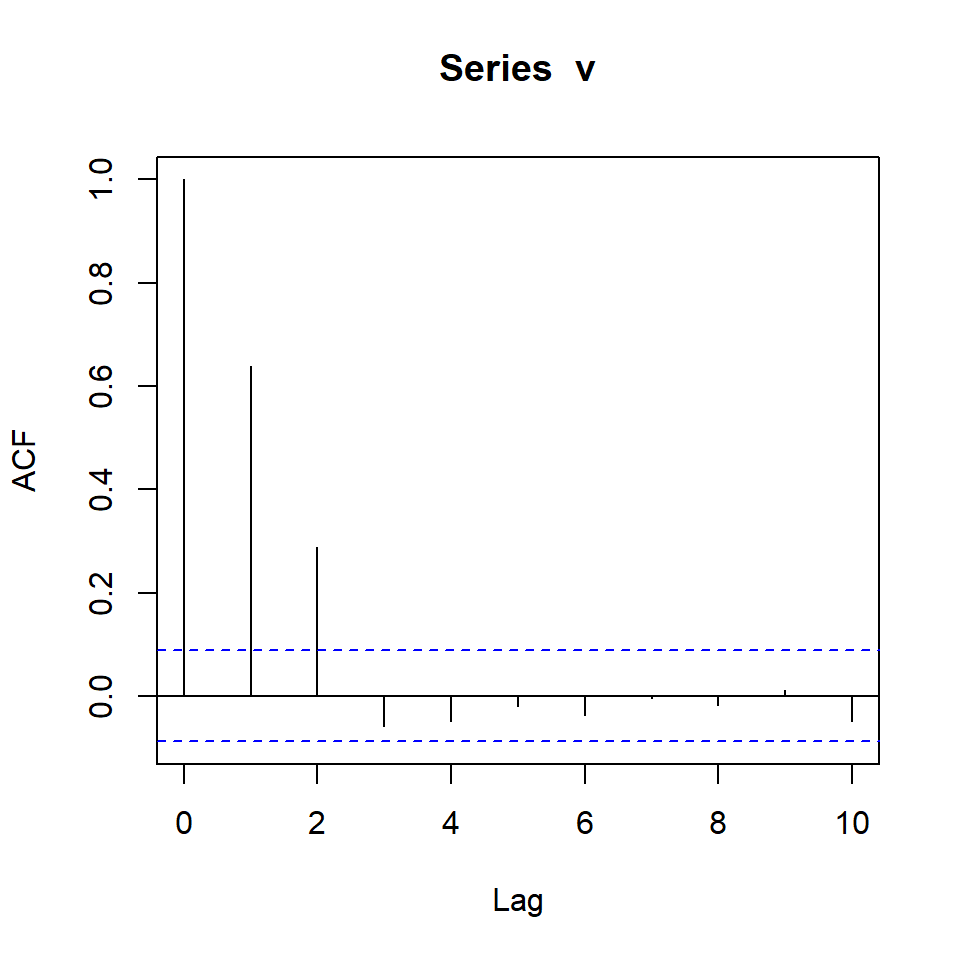

Medias móviles

Considere el ejemplo de medias móviles: \(v_t=\frac{1}{3}(w_{t-1}+w_{t}+w_{t+1})\)

La función de autocovariancia es definida por \[\gamma_v(t,t+h)=Cov(v_{t},v_{t+h})\]

Caso 1 \((h=0)\): \[\begin{align*}\gamma_v(t,t+0)&=Cov(v_{t},v_{t+0})=Var(v_t)\\ &=\frac{1}{9}Var(w_{t-1}+w_{t}+w_{t+1})\\ &=\frac{3}{9} Var(w_t)=\frac{1}{3} \sigma_w^2.\end{align*}\]

Caso 2 \((h=1)\): \[\begin{align*} \gamma_v(t,t+1)&=Cov(v_{t},v_{t+1}) \\ &=Cov\left[\frac{1}{3}(w_{t-1}+w_{t}+w_{t+1}),\frac{1}{3}(w_{t}+w_{t+1}+w_{t+2})\right]\\ &=\frac{1}{9}\left[ Cov(w_{t},w_{t})+Cov(w_{t+1},w_{t+1})\right]=\frac{2}{9}\sigma_w^2. \end{align*}\]

Caso 3 \((h=-1)\): Similarmente se obtiene \(\gamma_v(t,t-1)=\frac{2}{9}\sigma_w^2\)

Caso 4 \((h=2~o~h=-2)\):

\[\gamma_v(t,t+2)=\gamma_v(t,t-2)=\frac{1}{9}\sigma_w^2\]

Caso 5 \((h>2~o~h<-2)\):

\[\gamma_v(t,t+h)=0.\]

Entonces, \[\gamma_w(t,t+h)=\left\lbrace \begin{aligned} \frac{3}{9}\sigma_w^2, & & h = 0 \\ \frac{2}{9}\sigma_w^2, & & |h| = 1 \\ \frac{1}{9}\sigma_w^2, & & |h| = 2 \\ 0, & & |h| > 2, \end{aligned} \right.\]

- Su función de autocorrelación es \[\rho_v(h)=\left\lbrace \begin{aligned} 1, & & h = 0 \\ \frac{2}{3}, & & |h| = 1 \\ \frac{1}{3}, & & |h| = 2 \\ 0, & & |h| > 2, \end{aligned} \right.\]

Proceso lineal

Contenido

Modelos de series temporales

Procesos estacionarios

Estimación

Ejemplos

Proceso lineal

ARIMA(p,d,q)

En R

Proceso lineal

- Un proceso lineal, \(X_t\) es definido como una combinación lineal de los ruidos blancos \(w_t\) y es dado por:

\[X_t=\mu+\sum_{j=-\infty}^{\infty}\psi_j w_{t-j},~~~ \sum_{j=-\infty}^{\infty}|\psi_j| < \infty.\]

Se puede demostrar que su ACF es dada por \[\gamma_X(h)=\sigma_w^2 \sum_{j=-\infty}^{\infty}\psi_{t+h}\psi_j,~~~ \text{para } h \geq 0\]

Para el ejemplo anterior de medias móviles, note que es un caso particular con \(\psi_0=\psi_{-1}=\psi_{1}=1/3\), y \(\psi_k=0, k \neq -1,0,1.\)

Estacionariedad

- Concentremos en un modelo lineal con \(\psi_j=0,~~ \text{para}~~j<0\), i.e.

\[X_t=\mu+\sum_{j=0}^{\infty}\psi_j w_{t-j},~~~ \sum_{j=0}^{\infty}|\psi_j| < \infty.\]

- Se puede demostrar que es estacionario con:

\[E(X_t)=\mu,~~~\gamma_X(h)=\sigma_w^2 \sum_{j=0}^{\infty}\psi_{t+h}\psi_j,~~~ \text{para } h \geq 0\]

- Note que tiene forma de \(MA(\infty)\) y se puede presentarlo como:

\[\tilde{X}_t=X_t-\mu={\psi}(B)w_t\] donde \(\psi(B)=1+ \psi_1 B+ \psi_2 B^2+...\) es el operador de medias móviles de orden infinito.

Invertibilidad

El interés es expresar una serie temporal \(X_t\) en término de sus valores pasados \(X_{t-i}\) para \(i>0\).

Una serie temporal estacionaria \(X_t\) es invertible si se puede expresar como: \[X_t=c+w_t+\sum_{j=1}^\infty \phi_j X_{t-j}\] donde \(c\) es un vector constante, \(\phi_j,~j>0\) constantes, y \(\left\lbrace w_{t}\right\rbrace\) es ruido blanco con variancia \(\sigma_w^2\).

Representaciones de un modelo lineal

A partir de un modelo lineal estacionario e invertible: \[X_t-\sum_{j=1}^\infty \phi_j X_{t-j}=c+w_t\]

Calculemos la esperanza en ambos lados, se obtiene: \(\mu-\mu \sum\limits_{j=1}^\infty \phi_j =c\)

Sustituimos \(c\) en la ecuación anterior

\[X_t-\sum_{j=1}^\infty \phi_j X_{t-j}=\mu-\mu \sum_{j=1}^\infty \phi_j + w_t\] \[\Rightarrow (X_t-\mu) - \left(\sum_{j=1}^\infty \phi_j X_{t-j}- \sum_{j=1}^\infty \phi_j \mu \right)= w_t\]

- Podemos reescribir el modelo como:

\[\tilde{X}_t-\sum_{j=1}^\infty \phi_j \tilde{X}_{t-j}=w_t\] donde \(\tilde{X}_t=X_t-\mu\).

- Conocida como la representación de una serie temporal centrada, y es posible representarla como: \[\phi(B)\tilde{X}_t=w_t\]

donde \(\phi(B)= 1- {\phi}_1 B-{\phi}_2 B^2-...\) es el operador autorregresivo de orden infinito.

- Recordemos que un proceso lineal estacionario tiene esta representación:

\[\tilde{X}_t={\psi}(B)w_t\]

- Y un proceso invertible:

\[\phi(B)\tilde{X}_t=w_t\]

- Insertamos las dos ecuaciones:

\[\phi(B){\psi}(B)w_t=w_t\] o bien

\[\left(1- \phi_1 B- \phi_2 B^2-... \right) \left(1+ \psi_1 B+ \psi_2 B^2+... \right)w_t=w_t\]

De esta forma, \[\left(1- \phi_1 B- \phi_2 B^2-... \right) \left(1+ \psi_1 B+ \psi_2 B^2+... \right)=1\]

Esto implica que todos los coeficientes que acompañan a \(B^i~,i>0\) debe ser cero.

\[\left. \begin{eqnarray} & \psi_1-\phi_1 & = & 0 \\ & \psi_2-\psi_1\phi_1-\phi_2 &= & 0 \\ & \psi_3-\psi_1\phi_2-\psi_2\phi_1-\phi_3 & = & 0 \\ &\vdots &=& \vdots \end{eqnarray}\right.\]

- De esta forma, se puede obtener representaciones diferentes (AR o MA) de un modelo lineal.

Ejemplo

Considere un modelo AR(1): \(\phi(B)\tilde{X}_t=w_t\) donde \(\phi(B)= 1- {\phi}_1 B\).

Para obtener su representación \(MA(\infty)\), tenemos que \[\left(1- \phi_1 B \right) \left(1+ \psi_1 B+ \psi_2 B^2+... \right)=1\]

Abriendo la expresión:

\[\begin{split} \left(1- \phi_1 B \right) + \left(1- \phi_1 B \right) \psi_1 B + \left(1- \phi_1 B \right) \psi_2 B^2 \\ + \left(1- \phi_1 B \right) \psi_3 B^3 +... = 1 \end{split}\]

\[\begin{split} \Rightarrow 1- \phi_1 B + \psi_1 B- \phi_1 \psi_1 B^2 + \psi_2 B^2- \phi_1 \psi_2 B^3 \\ +\psi_3 B^3- \phi_1 \psi_3 B^4 + ... = 1 \end{split}\] \[\Rightarrow 1+ (\psi_1-\phi_1) B+ (\psi_2- \phi_1 \psi_1) B^2 + (\psi_3- \phi_1 \psi_2) B^3 + ... = 1\]

- lo cual significa que:

\[\left. \begin{eqnarray} & \psi_1-\phi_1 & = & 0 \\ & \psi_2-\psi_1\phi_1 &= & 0 \\ & \psi_3-\psi_2\phi_1& = & 0 \\ &\vdots &=& \vdots \end{eqnarray}\right.\]

- La representación de \(AR(1)\) como \(MA(\infty)\) es:

\[\psi_1=\phi_1,~\psi_2=\phi_1^2,~\psi_3=\phi_1^3,~...\]

- O sea:

\[X_t-\mu=\sum_{j=0}^{\infty}\phi_1^j w_{t-j}.\]

ARIMA(p,d,q)

Contenido

Modelos de series temporales

Procesos estacionarios

Estimación

Ejemplos

Proceso lineal

ARIMA(p,d,q)

En R

ARMA(p,q)

El modelo lineal con representación AR y MA de orden infinito es elegante pero dificulta el proceso de la estimación involucrando infinitos coeficientes.

El modelo de nuestro interés se centra en modelos que se pueden representar por medio de una cantidad finita de coeficientes.

\(X_t\) sigue un proceso ARMA(p,q) si satisface la siguiente ecuación:

\[\phi(B) \tilde{X}_t =\theta(B)a_t.\] donde:

\(\tilde{X}_t = (X_t-\mu_X)\), es decir \(\tilde{X}_t\) está centrada en cero.

\(\phi(B)=1-\phi_1 B -\phi_2 B^2-...-\phi_p B^p\) es el operador autorregresivo.

\(\theta(B)=1-\theta_1 B-\theta_2 B^2-...-\theta_q B^q\) es el operador de medias móviles.

Condiciones de estacionariedad e invertibilidad de ARMA(p,q)

La condición de estacionariedad se verifica con la ecuación característica del proceso autoregresivo \[\phi(B)=1-\phi_1 B -\phi_2 B^2-...-\phi_p B^p=0.\]

Si las raíces características de la ecuación característica están fuera del círculo unitario, el proceso AR(p) es estacionario.

De forma similar, la condición de invertibilidad se verifica con la ecuación característica del proceso de medias móviles

\[\theta(B)=1-\theta_1 B-\theta_2 B^2-...-\theta_q B^q=0.\]

- Si las raíces características de la ecuación característica están fuera del círculo unitario, el proceso MA(q) es invertible.

ARIMA(p,d,q)

En la práctica, muchas series son no estacionarias pero las diferencias consecutivas de orden \(d\) puede llegar a una serie estacionaria.

Sea \[\tilde{W}_t=\nabla^d \tilde{Z}_t=(1-B)^d \tilde{Z}_t\] la diferencia consecutiva de orden \(d\) de la serie \(\tilde{Z}_t\).

Suponga que después de realizar estas \(d\) diferencias \(\tilde{W}_t\) puede ser representado por un proceso ARMA(p,q), i.e.

\[(1-\phi_1 B -\phi_2 B^2-...-\phi_p B^p)\tilde{W}_t=(1-\theta_1 B-\theta_2 B^2-...-\theta_q B^q)a_t,\] O equivalentemente,

\[(1-\phi_1 B -\phi_2 B^2-...-\phi_p B^p)(1-B)^d \tilde{Z}_t=\] \[(1-\theta_1 B-\theta_2 B^2-...-\theta_q B^q)a_t.\]

ARIMA(p,d,q)

- Usando las notaciones del operador de diferencia, autoregresivo \(\phi(B)\) y de medias móviles \(\theta(B)\), sea \[\tilde{W}_t=\nabla^d \tilde{Z}_t=(1-B)^d \tilde{Z}_t\] la diferencia consecutiva de orden \(d\) de la serie \(\tilde{Z}_t\).

\[\phi(B)\nabla^d \tilde{Z}_t=\theta(B)a_t.\] donde:

\(\phi(B)=1-\phi_1 B -\phi_2 B^2-...-\phi_p B^p\) es el operador autorregresivo.

\(\theta(B)=1-\theta_1 B-\theta_2 B^2-...-\theta_q B^q\) es el operador de medias móviles. \(\nabla^d=(1-B)^d\) es el operador de \(d\) diferencias.

Este modelo es denominado modelo autoregresivo integrado de promedios móviles (en inglés: AutoRegressive Integrated Moving Average model).

Se denota con ARIMA(p,d,q).

ARIMA(p,d,q)

- El término “integrado” proviene del hecho de que cuando \(d=1\), \(Z_t\) se puede presentar como la suma: \[Z_t=W_t+W_{t-1}+W_{t-2}+...,\] i.e. obtener \(Z_t\) sumando (integrando) del proceso estacionario \(W_t\).

\[W_t+W_{t-1}+W_{t-2}+...\] \[=(Z_{t}-Z_{t-1})+(Z_{t-1}-Z_{t-2})+(Z_{t-2}-Z_{t-3})+...\] \[=Z_{t}~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~\]

En R

Contenido

Modelos de series temporales

Procesos estacionarios

Estimación

Ejemplos

Proceso lineal

ARIMA(p,d,q)

En R

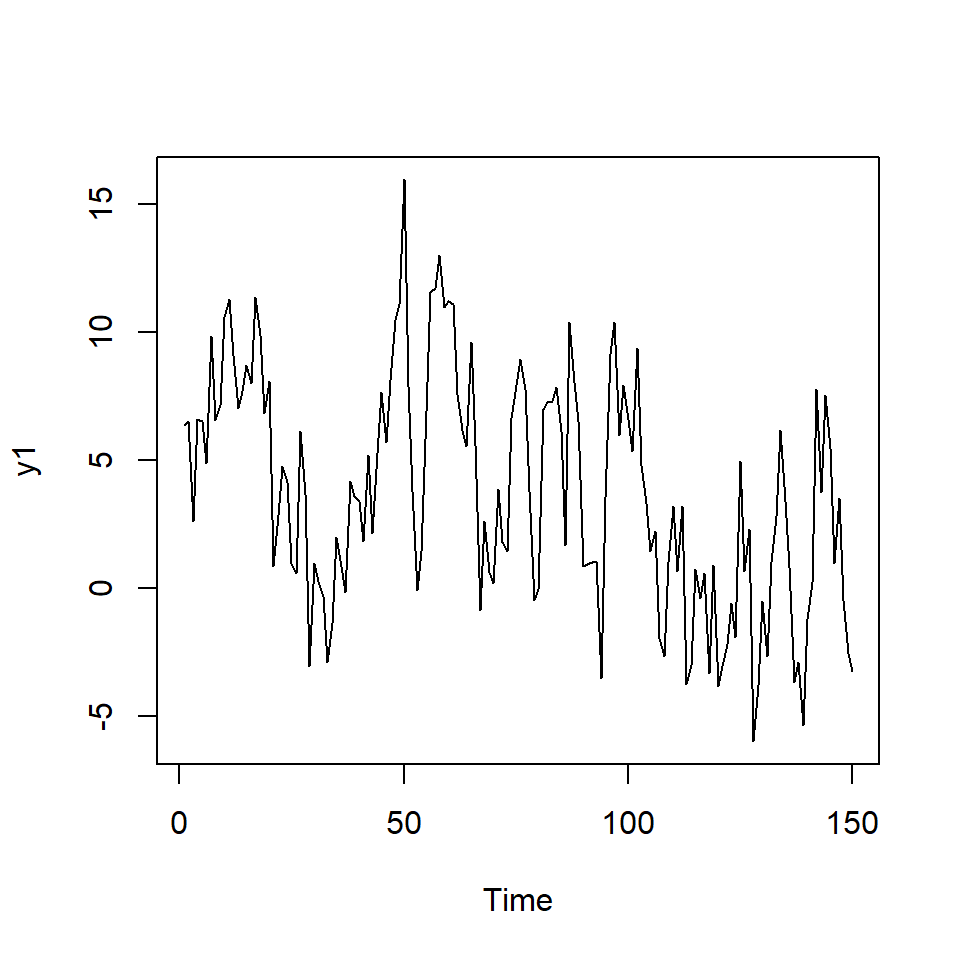

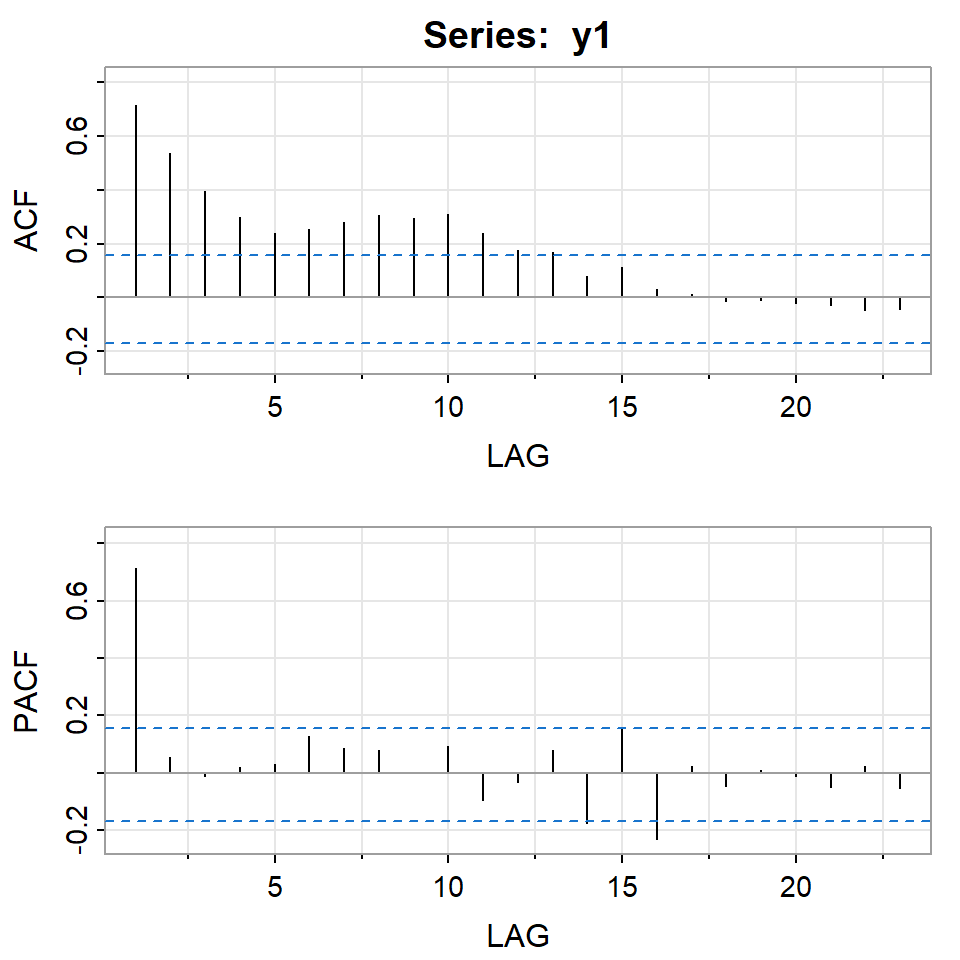

Ejemplo 1

m<-5 #la media del proceso

y1 <- arima.sim(n = 150, model = list(order = c(1,0,0),ar = c(0.8)),sd=3,rand.gen= rnorm) + m

ts.plot(y1)

[,1] [,2] [,3] [,4] [,5] [,6] [,7] [,8] [,9] [,10] [,11] [,12] [,13]

ACF 0.71 0.54 0.39 0.30 0.24 0.25 0.28 0.31 0.29 0.31 0.24 0.18 0.17

PACF 0.71 0.05 -0.01 0.02 0.03 0.13 0.09 0.08 0.00 0.09 -0.10 -0.03 0.08

[,14] [,15] [,16] [,17] [,18] [,19] [,20] [,21] [,22] [,23]

ACF 0.08 0.11 0.03 0.01 -0.01 -0.01 -0.02 -0.03 -0.04 -0.04

PACF -0.17 0.15 -0.23 0.02 -0.05 0.01 -0.01 -0.05 0.02 -0.05Series: y1

ARIMA(1,0,0) with non-zero mean

Coefficients:

ar1 mean

0.7218 3.6802

s.e. 0.0565 0.8971

sigma^2 = 9.791: log likelihood = -383.31

AIC=772.62 AICc=772.79 BIC=781.65

Training set error measures:

ME RMSE MAE MPE MAPE MASE

Training set -0.01837014 3.108109 2.511776 62.62337 162.6081 0.9317537

ACF1

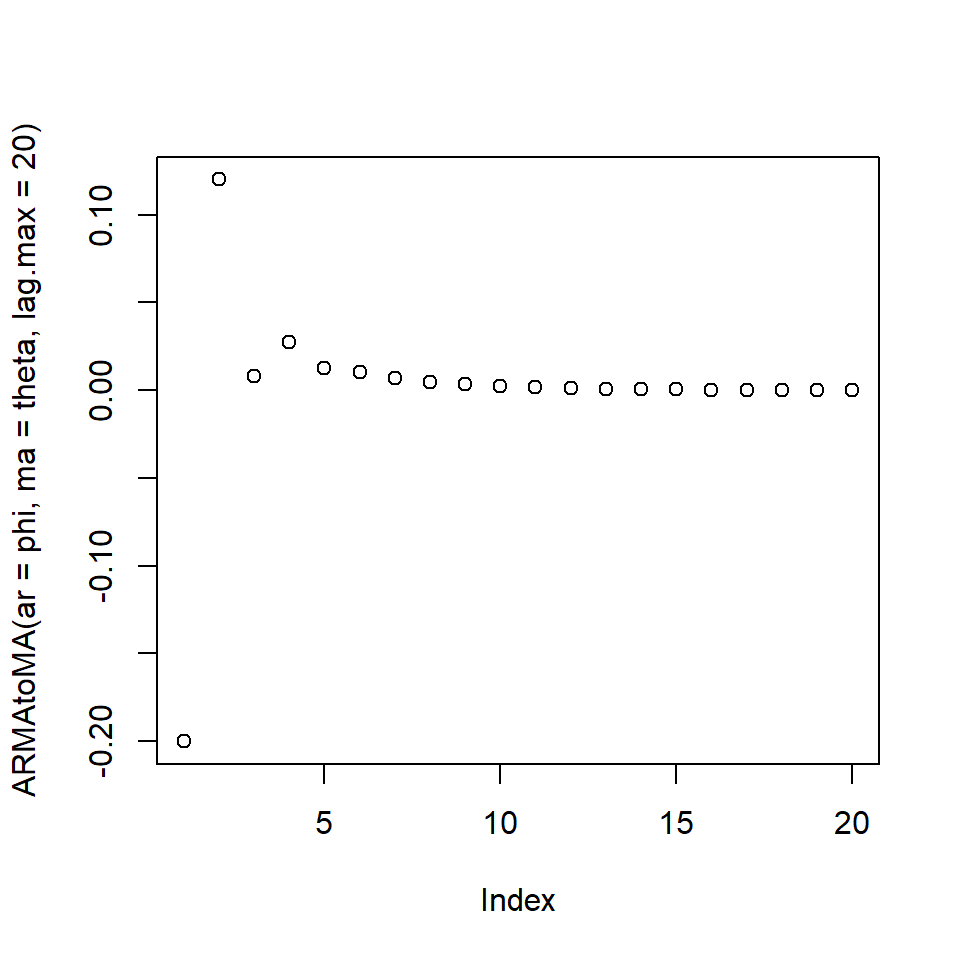

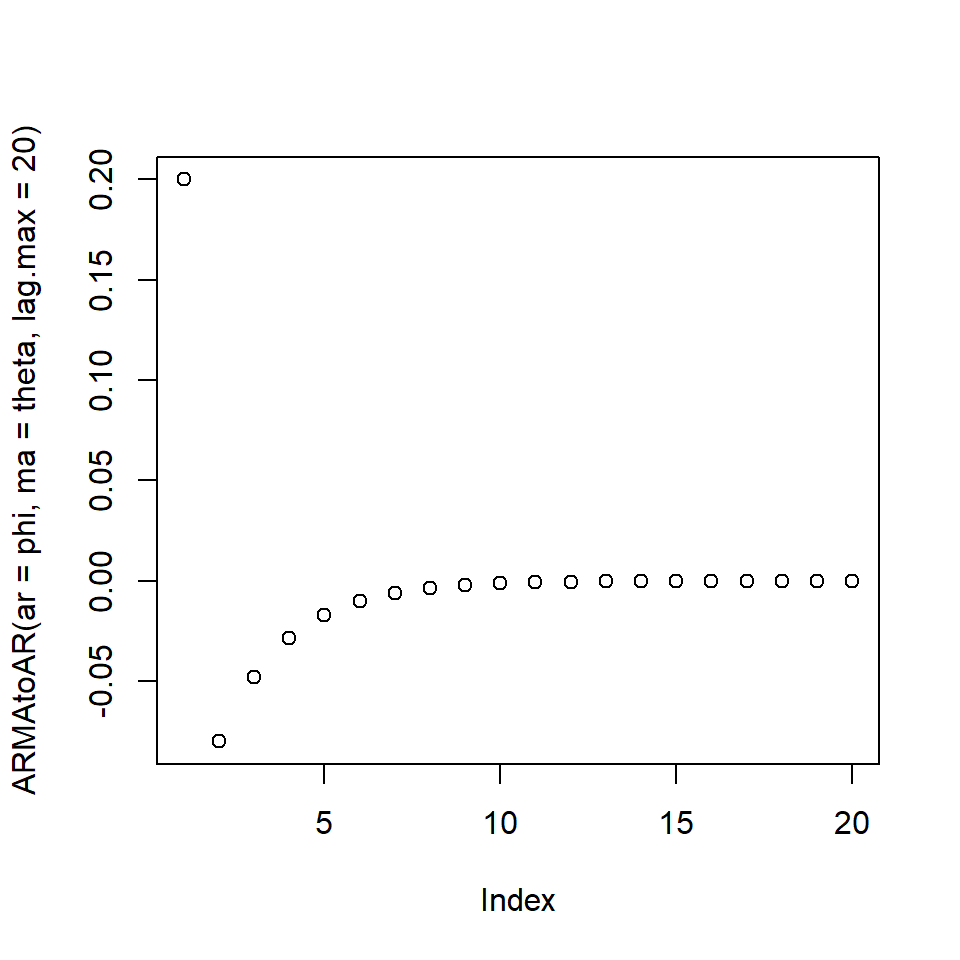

Training set -0.04000369Modelo lineal

[1] -0.20000 0.12000 0.00800 0.02720 0.01248[1] 0.20000 -0.08000 -0.04800 -0.02880 -0.01728

En la próxima clase veremos

Análisis espectral.

Paquetes en R

Para replicar los ejemplos de esta presentación, necesitan estos paquetes: