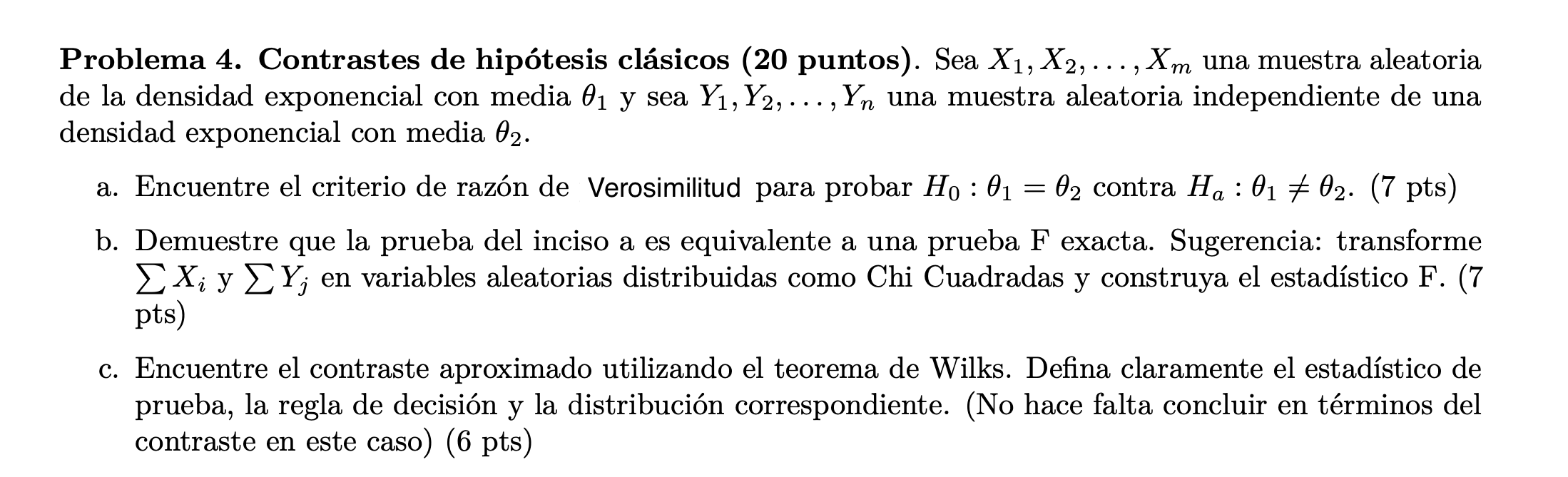

class: center, middle, inverse, title-slide .title[ # XS3310 Teoría Estadística ] .subtitle[ ## I Semestre 2023 ] .author[ ### Escuela de Estadística ] .date[ ### 09-06-2023 ] --- class: center, middle # ¿Qué hemos visto hasta ahora? Introducción a la Estadística Bayesiana: filosofía, historia y un poco de cálculo. # ¿Qué vamos a discutir hoy? Modelo Bayesiano. Distribuciones previas --- ## Proceso de modelación de parámetros. De ahora en adelante vamos a entender un modelo como el conjunto de los datos `\(X_1, \ldots, X_n,\)` la función de densidad `\(f\)` y el parámetro de la densidad `\(\theta\)`. Estos dos últimos resumen el comportamiento de los datos. Ahora para identificar este modelo se hace por partes, 1. La información previa `\(\pi(\theta)\)` es la información extra o basado en la experiencia que tengo del modelo. 2. Los datos es la información observada. La función de densidad `\(f\)` filtra y mejora la información de la previa. 3. La densidad posterior es la "mezcla" entre la información y los datos observados. Es una versión más informada de la distribución del parámetro. --- ## Función de verosimilitud Bajo el modelo estadístico anterior a `\(f_n(X|\theta)\)` se le llama **verosimilitud** o **función de verosimilitud**. **Observación**. En el caso de una función de verosimilitud, el argumento es `\(\theta\)`. **Ejemplo**. Sea `\(\theta\)` la proporción de aparatos defectuosos, con `\(\theta \in [0,1]\)` `$$X_i = \begin{cases}0 & \text{falló} \\ 1 & \text{no falló} \end{cases}$$` `\(\{X_i\}_{i=1}^n\)` es una muestra aleatoria y `\(X_i \sim Ber(\theta)\)`. - **Verosimilitud** `$$f_n(X|\theta) = \prod_{i=1}^n f(X_i|\theta) = \begin{cases}\theta^{\sum X_i}(1-\theta)^{n-\sum X_i} & X_i = 0,1~ \forall i \\ 0 & \text{si no}\end{cases}$$` --- - **Previa**: `$$\pi(\theta) = 1_{\{0\leq\theta\leq 1\}}$$` - **Posterior**: Por el teorema de Bayes, `\begin{align*} \pi(\theta|X) \propto \theta^y (1-\theta)^{n-y}\cdot 1 \\ &= \theta^{\overbrace{y+1}^{\alpha}-1}(1-\theta)^{\overbrace{n-y+1}^{\beta}-1} &\implies \theta|X \sim \text{Beta}(y+1,n-y+1) \end{align*}` - **Predicción**. *Supuesto*: los datos son secuenciales. Calculamos la distribución posterior secuencialmente: `\begin{align} \pi(\theta|X_1) & \propto \pi(\theta) f(X_1|\theta)\\ \pi(\theta|X_1,X_2) &\propto \pi(\theta) f(X_1,X_2|\theta) \\ &= \pi(\theta) f(X_1|\theta) f(X_2|\theta) \text{ (por independencia condicional)} \\ & = \pi(\theta|X_1)f(X_2|\theta)\\ \vdots & \\ \pi(\theta|X_1,\dots,X_n) & \propto f(X_n|\theta)\pi(\theta|X_1,\dots, X_{n-1}) \end{align}` Bajo independencia condicional no hay diferencia en la posterior si los datos son secuenciales. --- Luego, `$$\begin{align} g_n(X) & = \int_{\Omega} f(X_n|\theta) \pi(\theta|X_1,\dots, X_{n-1})~d\theta \\ & = P(X_n|X_1,\dots,X_{n-1}) \text{ (Predicción para }X_n) \end{align}$$` **Ejemplo**. Continuando con el ejemplo de los artefactos, `\(P(X_6>3000|X_1,X_2,X_3,X_4,X_5)\)`. Se necesita calcular `\(f(X_6|X)\)`. Dado que `$$\pi(\theta|X) = 2.6\times 10^{36}\theta^8 e^{-36178\theta}$$` se tiene `$$f(X_6|X) = 2.6 \times 10^{36} \int_{0}^\infty \underbrace{\theta e^{-\theta X_6}}_{\text{Densidad de } X_6} \theta^8 e^{-36178\theta}~d\theta= \dfrac{9.55 \times 10^{41}}{(X_6+36178)^{10}}$$` Entonces, `$$P(X_6>3000)=\int_{3000}^{\infty} \dfrac{9.55\times10^{41}}{(X_6+36178)^{10}}\; dX_6 = 0.4882$$` --- ```r func<-function(x){9.55*10^41/(x+36178)^10} integrate(func,lower=3000,upper=Inf) ``` ``` ## 0.4879558 with absolute error < 1.5e-05 ``` La vida mediana se calcula como `\(\dfrac{1}{2} = P(X_6>u|X)\)`. La vida media se calcula como `\(E(X_6|X) = \int_{0}^{\infty} x_6 f(x_6|X) dx_6\)`. ```r func<-function(x){x*9.55*10^41/(x+36178)^10} integrate(func,lower=0,upper=Inf) ``` ``` ## 4519.75 with absolute error < 0.41 ``` --- ## Distribuciones previas **Ejemplo**: * Podríamos usar una previa no informativa, de manera que `\(\theta \sim Unif(0,B)\)` donde `\(B\)` va a representar un valor arbitrario muy grande. * Ahora vamos a suponer que tenemos una muestra aleatoria `\(X_1 , X_2 , ... , X_n\)` tal que `\(X_j \sim Poisson(\theta)\)`, por lo que se cumple que `\(\mathcal{L}(\theta|x) = \frac{ \theta^{\sum_{j=1}^{n}x_j} e^{-n\theta} }{\prod_{j=1}^{n} x_{j}! }\)`. Para llegar a cuál sería la función de densidad a posteriori podemos utilizar el Teorema de Bayes: `$$\pi(\theta |x) = \frac{\mathcal{L}(\theta |x)\pi(\theta)}{\int_{0}^{+\infty} \mathcal{L}(\theta|x)\pi(\theta)}$$` --- ## Distribuciones previas Y dada la distribución a previa que escogimos entonces tenemos lo siguiente: `$$\mathcal{L}(\theta |x)\pi(\theta) = \frac{ \theta^{\sum_{j=1}^{n}x_j} e^{-n\theta} }{\prod_{j=1}^{n} x_{j}!} \cdot \frac{1}{B}$$` Este es el numerador de la expresión del Teorema de Bayes, pero por lo expresado anteriormente, para encontrar la posteriori, sabemos que `\(\pi(\theta| x) \propto \mathcal{L}(\theta| x)\pi(\theta)\)`. Esto quiere decir que debemos encontrar el núcleo (o la parte variable) de esta expresión e identificar a qué función de densidad conocida pertenece. Por lo tanto, `$$\pi(\theta| x) \propto \mathcal{L}(\theta |x)\pi(\theta)$$` `$$\Rightarrow \pi(\theta| x) \propto \frac{ \theta^{\sum x_j} e^{-n\theta} }{\prod x_{j}! } \cdot \frac{1}{B} \propto \theta^{n\bar{x}} e^{-n\theta}$$` --- ## Distribuciones previas `$$\Rightarrow \pi(\theta| x) \propto \frac{ \theta^{\sum x_j} e^{-n\theta} }{\prod x_{j}! } \cdot \frac{1}{B} \propto \theta^{n\bar{x}} e^{-n\theta}$$` Este es el núcleo de una distribución Gamma con `\(\alpha = n\bar{x} + 1\)` y `\(\beta = n\)`. Por lo tanto, podemos decir que la distribución a posteriori para `\(\theta\)` es una `\(Gamma(n\bar{x} + 1, n)\)`, denotado como `\(\theta|x \sim Gamma(n\bar{x} + 1, n)\)`. Nótese como dato curioso que esta es una distribución centrada en `\(\frac{n\bar{x} + 1}{n} = \bar{x} + \frac{1}{n}\)`, el cual es un valor muy cercano a `\(\bar{x}\)`, especialmente con un `\(n\)` muy grande. Nosotros ya sabíamos que `\(\bar{x}\)` es el estimador de máxima verosimilitud para `\(\theta\)`, por lo tanto si no tenemos mucha información sobre `\(\theta\)` a previa entonces tendría sentido basar nuestro conocimiento posterior alrededor de su estimador máximo verosímil. Esto nuevamente representa como el análisis Bayesiano con previas no informativas es muy similar al análisis frecuentista. --- ## Distribuciones previas Siguiendo con el mismo ejemplo, supongamos que tenemos más información sobre nuestro parámetro `\(\theta\)`, ¿cómo podríamos simularla? Sabemos que `\(\theta\)`, al ser la media de una población Poisson, debe ser mayor a cero. Ya utilizamos la distribución Uniforme como una previa no informativa, por lo que sería contraproducente usarla cuando tenemos más información. Podríamos utilizar una distribución Gamma (o alguna de sus variaciones) ya que esta es para valores mayores que cero y además se pueden escoger parámetros `\(\alpha\)` y `\(\beta\)` de manera que satisfagan nuestro conocimiento inicial sobre `\(\theta\)`. Este `\(\alpha\)` y `\(\beta\)` llevan el nombre de **hiperparámetros** y podríamos definirlos como los parámetros de la distribución de un parámetro. Siguiendo el ejemplo podemos decir que inicialmente `\(\theta \sim Gamma(\alpha, \beta)\)`. Es decir, `$$\pi(\theta) = \frac{ \beta^{\alpha} \theta^{\alpha - 1} e^{-\beta \theta} }{ \Gamma(\alpha) }$$` --- ## Distribuciones previas Podemos proceder a encontrar la distribución posterior: `$$\pi(\theta|x) = \frac{\mathcal{L}(\theta |x)\pi(\theta)}{\int_{0}^{+\infty} \mathcal{L}(\theta|x)\pi(\theta)} \propto \mathcal{L}(\theta |x)\pi(\theta) = \frac{ \theta^{n\bar{x}} e^{-n\theta} }{\prod x_{j}! } \cdot \frac{ \beta^{\alpha} \theta^{\alpha - 1} e^{-\beta \theta} }{ \Gamma(\alpha) }$$` `$$\propto \theta^{n\bar{x}} e^{-n\theta} \cdot \theta^{\alpha - 1} e^{-\beta \theta} = \theta^{n\bar{x} + \alpha - 1} e^{-\theta(n + \beta)}$$` Este es el núcleo de una Gamma con parámetros `\(n\bar{x} + \alpha\)` y `\(n + \beta\)`. Por lo tanto concluimos que `\(\theta|x \sim Gamma(n\bar{x} + \alpha , n + \beta)\)`. Solo con propósitos de comparación podemos observar que esta distribución tiene media `\(\frac{n\bar{x} + \alpha}{n + \beta}\)` la cual la podemos reescribir como `\(\frac{n\bar{x} + \beta\left( \frac{\alpha}{\beta}\right) }{n + \beta}\)`. Podemos ver que esta tiene la forma de un promedio ponderado de la media muestral `\(\bar{x}\)` y de la media a previa `\(\frac{\alpha}{\beta}\)`. Entre mayor sea el tamaño de la muestra, mayor influencia van a tener los datos sobre la información posterior, mientras que si el `\(\beta\)` es más grande, entonces mayor influencia va a tener la previa sobre la posteriori. --- ## Distribuciones previas <img src="figs/prioripost.jpeg" alt="inv" style="float:center;width:550px;"/> Función de densidad a previa Gamma con `\(\alpha = 4\)` y `\(\beta = 2\)` (azul) y a posteriori (roja), utilizando `\(n=10\)` y `\(\bar{x} = 3.5\)` (línea punteada) para una muestra aleatoria de una población Poisson( `\(\theta\)` ). --- ## Distribuciones previas En la figura anterior podemos observar la diferencia entre la función de densidad a previa (utilizando `\(\alpha = 4\)` y `\(\beta = 2\)`) y la función de densidad a posteriori si hubiésemos obtenido una muestra de tamaño 10 cuyo promedio fuera de `\(3.5\)`. Podemos ver que antes de observar los datos la previa nos indicaba que la media era de 2. Cuando observamos los datos la media muestral era de `\(3.5\)` por lo que nuestro conocimiento a posteriori se "modificó" para representar esta nueva información. Noten como la función de densidad a posteriori tiene una media más cercana al valor observado en la muestra y como valores alrededor de `\(3.5\)` se volvieron más probables que antes. --- ## Distribuciones previas En estadística Bayesiana es posible modelar los hiperparámetros de la distribución de un parámetro. Por ejemplo, yo podría trata el `\(\alpha\)` de este ejemplo como un parámetro desconocido al cual le puedo modelar la incertidumbre por medio de una distribución a previa, supongamos que por medio de otra Gamma con hiperparámetros `\(\alpha^{\prime}\)` y `\(\beta^{\prime}\)`. Esto ocasiona que tengamos distintas etapas de previas en nuestro modelo: `$$X_1 , X_2 , ... , X_n \text{ t.q. }X_j \sim Poisson(\theta)$$` `$$\theta|\alpha \sim Gamma(\alpha, \beta)$$` `$$\alpha \sim Gamma(\alpha^{\prime}, \beta^{\prime})$$` --- ## Distribuciones previas Este tipo de modelo se denomina un **modelo Bayesiano jerárquico** y es el tipo de modelo más utilizando en la práctica pues tiene varias ventajas sobre algunos análisis frecuentistas. Sin embargo presentan un problema y es que en muy pocas ocasiones se puede llegar a un modelo a posteriori conocido por lo que se necesitan de simulaciones numéricas para poder hacer el análisis Bayesiano. Aunque existen muchos métodos hoy en día el más popular sigue siendo el método de cadenas de Markov Monte Carlo (MCMC) mediante muestreo de Gibbs. Dependiendo de la complejidad del modelo este requiere de mucha potencia computacional, por lo que estos modelos no eran muy utilizados en los inicios de la Estadística Bayesiana. Fue hasta la década de los 90s, donde la población en general tuvo mayor acceso a computadoras más poderosas, donde las técnicas Bayesianas empezaron a cobrar una mayor relevancia. Hasta el momento hemos hecho la selección de la previa un poco intuitivamente, sin embargo en la práctica la selección de la previa puede deberse a varios factores. --- ## Selección de distribuciones previas 1. Previas informativas 2. Previas no informativas # Ejercicio:  --- class: center, middle ## ¿Qué discutimos hoy? Estadística Bayesiana, Distribuciones previas (a priori). ## ¿Qué nos falta para terminar el curso? Tipos de distribuciones previas, estadística Bayesiana: inferencia (estimación puntual, intervalos de credibilidad y factor de Bayes).